模型微调模块

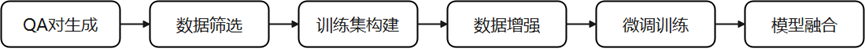

融合检索方案中会使用向量模型对知识进行向量化用于后续计算向量相似度,同时使用重排序模型对多路检索结果进行查询与知识片段的相关性排序,提取出最相关的知识片段。然而,通用的向量化模型基于开源语料训练而来,没有Gauss数据库知识,因此在进行向量化之后语义丢失,导致相似度计算时效果达不到最优;同样的,由于重排序模型同样基于开源语料训练而来,在判断查询与知识片段相关性时无法理解Gauss知识导致排序紊乱,进而降低检索模块的召回率。因此需要使用Gauss数据库知识对模型进行微调,使得模型在处理相关数据时的性能有所提升。模型微调的主要流程如下图图1所示:

其中,各部分说明如下:

QA对生成:基于Gauss数据库文档与运维文档,构建point-question-answer思维链,使用大模型一步一步生成基础的问答对;

数据筛选:使用问答对中的问题,进行向量检索,如果回答不在top5中,则问答对被舍弃;

训练集构建:将问答对进行随机打乱,按照1:9比例拆分成训练集与测试集;

数据增强:使用问答对中的问题,进行向量检索,取top200结果,从中丢弃top5结果以及回答,随后采样一定比例作为难负例(Hard Negative);

说明:

难负例(Hard Negative)在机器学习和信息检索领域中指的是那些对于模型来说难以正确分类的负样本。这些样本在特征空间中与某些正样本非常接近,或者模型在预测时对这些样本的置信度很高但实际上它们是负样本。难负例对于模型的训练尤为重要,因为它们能够提供更多的信息,帮助模型更好地学习和区分那些边界模糊或容易混淆的样本。

说明:

难负例(Hard Negative)在机器学习和信息检索领域中指的是那些对于模型来说难以正确分类的负样本。这些样本在特征空间中与某些正样本非常接近,或者模型在预测时对这些样本的置信度很高但实际上它们是负样本。难负例对于模型的训练尤为重要,因为它们能够提供更多的信息,帮助模型更好地学习和区分那些边界模糊或容易混淆的样本。微调训练:训练每一轮均对难负例进行随机采样,保证负例多样性,同时调整学习率、batch_size等参数进行模型调优;

模型融合:为避免模型过拟合,可将基础模型与微调模型进行权重融合。